I “pirati” che addestrano l’Intelligenza Artificiale

"Ci sono aziende che “allenano” l’AI violando il copyright degli artisti o la privacy dei cittadini. Si nascondono dietro Onlus di facciata. E spesso sfruttano lavoratori sottopagati nel Terzo mondo. Noi creativi chiediamo regole a livello europeo”. Parla il portavoce del network Egair

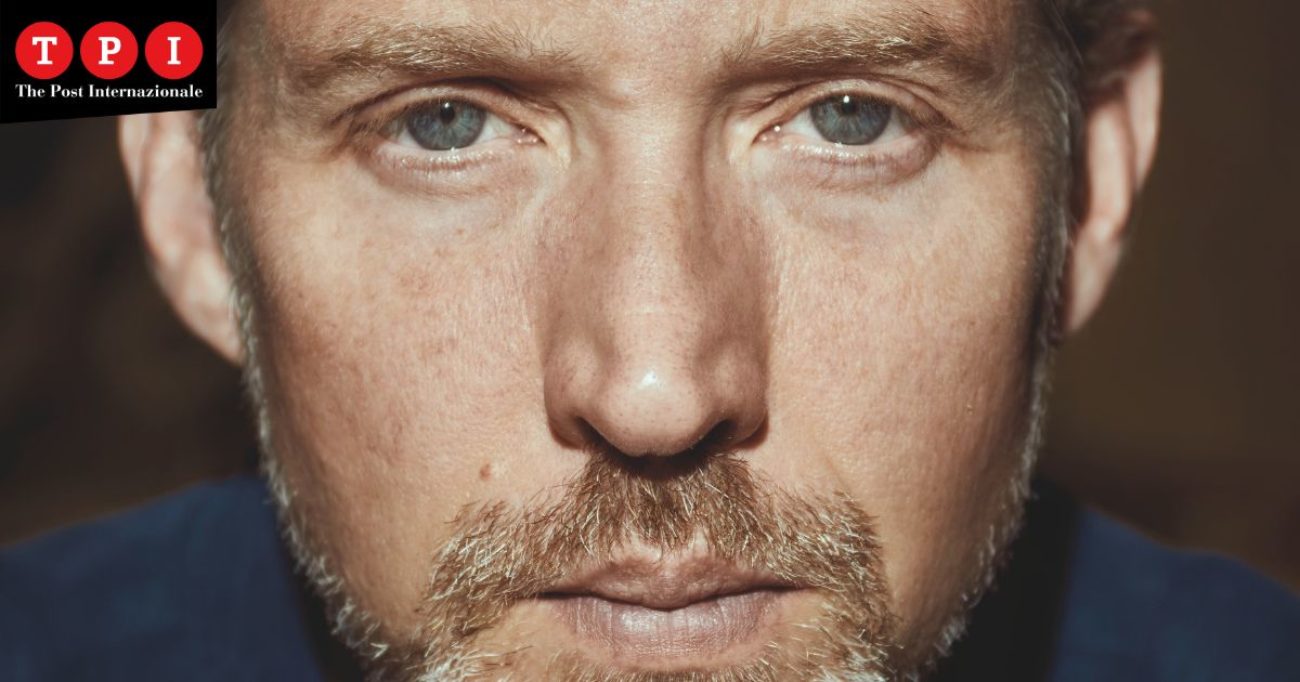

«Per addestrare le Intelligenze Artificiali servono grosse quantità di dati che vengono raccolti da alcune aziende in maniera illegittima, violando il copyright e la privacy dei cittadini». A lanciare l’allarme a TPI è il fumettista Francesco Archidiacono, co-fondatore e portavoce di Egair (European Guild for AI Regulation), «un network di associazioni e creativi europei nato a gennaio 2023 su iniziativa italiana». «Sono oltre 100mila i creativi che rappresentiamo», spiega: «Siamo i loro portavoce quando si tratta di andare a parlare con le istituzioni europee e nazionali di Intelligenza Artificiale (AI). Il motivo per cui siamo nati è dedicarci alla difesa dei diritti dei creativi, ma anche dei cittadini europei in generale, quando si parla di dati e aziende che offrono servizi di AI».

Voi da tempo denunciate che i nostri dati vengono sfruttati da alcune aziende che si occupano di Intelligenza Artificiale senza il nostro consenso. In che modo ciò avviene?

«Queste aziende e/o organizzazioni usano dei bot che perlustrano il web. Ad esempio, scaricano da siti, piattaforme e social delle immagini che poi vanno a comporre i data set che vengono utilizzati per “allenare” l’AI. Queste immagini vengono prese, etichettate (descritte in maniera testuale) e poi inserite nel data set, una sorta di database su cui si basa l’Intelligenza Artificiale».

L’etichettatura delle immagini viene eseguita da una “macchina” o manualmente da un essere umano?

«Non sempre il sistema è automatizzato. Molte immagini, quando vengono caricate sui siti, dispongono già delle relative informazioni, ma in altri casi vengono inviate ad aziende con sede in Paesi del terzo mondo dove una serie di lavoratori, probabilmente sotto pagati, fanno a mano il lavoro di etichettatura o di filtro. Questi lavoratori eliminano anche i contenuti più tossici. Su questo argomento c’è un dibattito in corso: in particolare sul fatto che queste persone passano ore e ore ogni giorno a guardare contenuti violenti di vario tipo per evitare che finiscano nei data set».

Che genere di immagini vengono prese e utilizzate?

«Di tutti i tipi. In alcuni casi il modo in cui viene fatto è in spregio al copyrighy e alla privacy delle persone. Ci sono foto personali di chiunque, ma anche dati biometrici come le voci dei doppiatori, degli attori…».

Ma com’è possibile che ciò venga fatto senza che nessuno dica nulla?

«In alcuni casi queste aziende si “nascondono” dietro le eccezioni al copyright per ricerca accademica».

Mi spieghi meglio.

«L’azienda X finanzia, o magari fonda, un’associazione no-profit europea che può scaricare questi contenuti coperti da copyright o privacy perché opera fine accademico. Una volta acquisite, le immagini vengono girate all’azienda principale, che le usa per il training della propria AI. Il caso più famoso è quello legato a un’associazione no-profit tedesca che ha costruito un data set di cinque miliardi di immagini, tutte consultabili: quel data set è pieno di contenuti coperti da copyright, ma essendo di una no-profit che opera per ricerca accademica non è un problema… Peccato però che l’associazione no-profit sia finanziata da un’azienda che non è affatto no-profit. Anzi, ricava dei guadagni per i suoi AI…».

Ma queste immagini coperte da copyright vengono utilizzate solo per allenare l’AI o anche pubblicamente? Ad esempio: posso ritrovare una mia foto in un prodotto creato dall’AI?

«Che queste immagini giochino un ruolo fortissimo nell’output (nel mondo reale, ndr) lo sappiamo per certo, ce lo conferma il fenomeno dell’overfitting».

Cioè?

«Nel momento in cui viene effettuato il training dell’AI, il machine learning, l’Intelligenza Artificiale prende le immagini e le rappresenta nel suo “mondo” come parametri statistici. Più un’immagine è presente più pesa a livello statistico e quindi aumentano le possibilità che il risultato dell’AI sia simile all’immagine di partenza. Questo è successo lo scorso anno con la ragazza afghana fotografata da Steve McCurry, la famosa immagine di copertina del National Geographic: per diverso tempo, se sulla piattaforma si scriveva “immagine di ragazza afghana”, venivano proposte copie identiche della foto di McCurry. Questo perché? Perché quella è una delle foto più famose di sempre e nel data set di quell’AI era presente in maniera sproporzionata rispetto ad altre immagini di ragazze afghane generiche. Quindi l’AI non riusciva a non generare un’immagine simile».

Si può dire, quindi, che i data set sono la base delle AI?

«Pochi giorni fa un impiegato di OpenAI, l’azienda di ChatGpt, ha scritto un post interessante in cui parla del fatto che negli ultimi mesi ha addestrato una marea di modelli di AI: ciò di cui si è reso conto è che tutti questi modelli, a lungo andare, tendono a rappresentare sempre le stesse cose presenti nei data set e che quindi l’output (il risultato, ndr) di un’AI non dipende dall’architettura dell’AI, non dipende dall’algoritmo o da come sono scritte le regole, ma dipende dal data set. Le immagini o file presenti nel data set giocano un ruolo molto più importante di quanto pensavamo inizialmente. Insomma, la macchina non può uscire fuori dal data set. È una macchina predittiva che segue dati statistici sulla base dei dati che le vengono forniti».

Tutte le risposte che l’AI ci può dare sono basate sulle informazioni che noi umani le abbiamo dato?

«Esatto. Sono esclusivamente basate su quelle».

Quindi non si tratta di intelligenza autonoma, indipendente. Ma di un’intelligenza basata sull’archivio “interno” che le viene fornito a monte dall’uomo.

«Esatto. Ma questa è, diciamo, anche la base dell’AI, nel senso che un’AI non è realmente intelligente: è qualcosa che non può uscire fuori dal suo set di regole di partenza».

L’AI non è in grado di raccogliere informazioni autonomamente?

«No. Ragiona solo con quello che ha nel suo data set di partenza. C’è tutta la fase iniziale che è umana: ad esempio la scelta dei dati su cui lavorare».

E in futuro? Tra qualche anno faremo i conto con un’AI in grado di auto-informarsi?

«Quello che ci dicono tutti gli esperti in materia è che non sono macchine addestrate per fare questo. Non sono macchine che possono diventare “umanamente intelligenti”. Non abbiamo le strutture perché diventino intelligenti. Sono, in fin dei conti, delle macchine che si rifanno alla macchina di Turing. Magari in futuro, con i computer quantistici, ciò potrà avvenire, ma non è quello di cui parliamo ora. Ora parliamo di servizi che vengono offerti da aziende sulla base di data set».

Quindi se io, ipoteticamente, fornisco all’AI informazioni razziste, questa non potrà non essere razzista nei risultati che produrrà…

«Esatto. Questa è una cosa che abbiamo già visto accadere. Sono frequenti i problemi nel riconoscimento facciale delle persone di colore. Ad esempio, le auto a guida autonoma hanno bisogno di un’AI che riconosca i pedoni per evitarli, ma in alcuni casi non riconoscono i pedoni di colore perché nei data set di partenza non ci sono abbastanza immagini di persone di colore. Questo è uno dei motivi per cui anche Google inizialmente non aveva voluto rilasciare le prime versioni delle sue AI generative: si erano resi conto che, ad esempio, per una loro AI un avvocato era sempre uomo. O ancora, ad esempio, una persona autistica veniva rappresentata tendenzialmente con un ragazzo bianco molto triste o che fa i puzzle».

Ciò significa che qualsiasi forma di AI è controllabile dall’essere umano e quindi può essere utilizzata per i propri scopi…

«Il problema non sono le AI e quello che possono fare, ma le aziende che le controllano, che non hanno alcun obbligo di trasparenza. Noi non sappiamo cosa mettono nei data set. Ma non solo: per uno scienziato che si occupa di queste cose – e si figuri per un cittadino comune – è praticamente impossibile capire come è costituito il “mondo privato” dell’AI, il dietro le quinte: si tratta di uno spazio multidimensionale che segue criteri da macchina, non da umano. Occorre un controllo a monte sui data set. Al momento non ha senso parlare di violazione di copyright o della privacy negli output (risultati, ndr), si risolve tutto quanto ragionando sugli input: su come viene costruito il data set, su cosa e come viene preso. È lì che sono le irregolarità».

Un’AI indipendente sarebbe possibile?

«Sarebbe bellissimo avere AI pubbliche, perfette, addestrate in maniera etica e pulita, senza pregiudizi. Ma non è possibile. Non è la direzione verso cui si sta andando. Inoltre ci sono dei limiti tecnici importanti: le AI addestrate su cinque miliardi di immagini hanno degli importanti costi a livello economico-ambientale. E cinque miliardi sono tante, tantissime, ma poche rispetto alle 22 miliardi che ogni giorno vengono cliccate sul web… Per un’AI neutrale dovresti creare un data set enorme che nessuno sarebbe in grado di gestire con costi economici ed ambientali improponibili”

Cos’hanno fatto ad oggi l’Ue e il Governo italiano per regolamentare questa spaventosa novità tecnologica?

«L’Ue si è mossa già nel 2019 con l’AI Act, un documento che fino a febbraio scorso non era pensato per regolamentare le AI come intendiamo ora. Era un documento rivolto agli utenti e alla loro protezione: non parlava per nulla di AI generative. Poi a febbraio è esploso ChatGpt e si sono tutti preoccupati del rischio che c’è nei servizi che vengono proposti. Quindi l’AI Act è cambiato molto, diventando un documento orizzontale il cui obiettivo è cercare di prendere ogni aspetto di ciò che è AI e ricondurlo a ogni disciplina europea. Ad oggi, tra i vari punti, è stato raggiunto, anche su nostra iniziativa, qualcosa di importante. Sto parlando dell’articolo 28 b, che prevede alcuni requisiti che devono seguire coloro che offrono servizi di AI generative. Tra questi c’è anche un requisito di trasparenza sui contenuti. Il motivo per cui è stato inserito è, cito uno dei relatori, “per permettere a chiunque di andare a vedere cosa c’è nel data set, vedere se ci sono contenuti coperti da copyright per i quali non si è data autorizzazione e, nel caso, andare a denunciare le aziende”. Si tratta di un primo importante passo. Noi, come i parlamentari europei con cui parliamo, siamo convinti che con questa tecnologia così potenzialmente dannosa, senza regolamentazioni, non si prospera. Anzi, si va solo incontro a disastri sociali ed economici».

E il Governo italiano?

«Ci abbiamo parlato. E devo dire che abbiamo avuto supporto. A maggio è stato approvato un ordine del giorno in cui si chiedeva un impegno sulla tutela del copyright. Ora, è notizia di questi giorni, l’onorevole Bergamini (Forza Italia, ndr) ha presentato un’interrogazione parlamentare sul tema. Al momento una manciata di aziende americane e una britannica – che sull’AI sono più avanti di quanto le aziende europee potranno mai essere, dato che ci lavorano da anni – prendono dati di creativi europei, in particolare italiani, ci addestrano le loro AI e poi vengono qui da noi a vendere i loro servizi erodendo lavoro a coloro da cui hanno preso la creatività…».

Cosa pensa della nomina di Giuliano Amato, costituzionalista 85enne, come presidente della nuova Commissione sull’Intelligenza Artificiale?

«La scelta fa notizia… Ma il problema, aldilà di Amato, è l’indirizzo che vorranno dare la Commissione e il Governo. Non mi interessa chi è a capo della commissione X o Y, non so neanche se serve… A noi interessa cosa fa l’Europa».

A suo avviso l’Europa è in ritardo sulla regolamentazione dell’AI?

«Siamo in ritardo, ma è anche vero che non si poteva stare al passo… Lo sviluppo ha sorpreso un po’ tutti. A gennaio, quando noi ne abbiamo cominciato a parlare con i relatori dell’AI Act europeo, ci è stato detto: “Noi nel 2019 abbiamo visto che c’era questo rischio, ma quando ne abbiamo parlato nessuno ci ha ascoltato perché sembrava fantascienza”. La cosa importante è che si sta lavorando. E tanto».

Qual è il futuro?

«Considerando dove stiamo andando, credo che il futuro sia più roseo di quello che si pensi. A patto che si continui a lavorare come si sta lavorando. A me piace pensare un futuro in cui i creativi riprendono possesso dei loro dati e vengono considerati una risorsa. In cui abbiano il controllo dei loro dati e ne facciano ciò che vogliono. Con aziende che offrono servizi di AI generative costruiti in maniera etica».

A proposito di etica, cosa ne pensa di ChatGpt?

«Il mio parere è assolutamente negativo. Le dico di più: non ci si può fidare di OpenAI. Hanno più volte dichiarato pubblicamente di non essere interessati ai danni che il loro lavoro potrebbe generare… A giugno Sam Altman, uno dei co-fondatori, nonché attuale Ceo di OpenAI, è andato al Congresso americano e ha parlato della necessità di avere delle regole sull’AI perché sono pericolose e vanno regolamentate e per questo il congresso deve rivolgersi alla loro azienda per avere una guida in merito… Qualche mese dopo lo stesso Altman è intervenuto da remoto a un evento in Italia in cui ha dichiarato che l’AI non è affatto pericolosa e che non servono regolamentazioni perché servirebbero solo a rallentare il progresso… Dichiarazione rilevante, a mio avviso, dato che è stata rilasciata in un Paese europeo proprio mentre l’Ue si sta approcciando al tema…».

Va però detto che alcune AI hanno un peso, anche etico, importante. Salvano vite.

«Il problema non è la tecnologia, ma come le aziende la mettono in atto. In ambito medico è chiaro che l’AI può essere molto importante. Inoltre ci semplifica, e ci semplificherà sempre di più, la vita. Bisogna intervenire sulle sue applicazioni specifiche, non sulla tecnologia in modo generico. Il problema etico va considerato».

Secondo Paolo Benanti, teologo scelto dal segretario generale dell’Onu a far parte del Gruppo di lavoro consultivo sui rischi, le opportunità e la governance internazionale dell’AI, bisogna «tenere al centro l’umano».

«Quello che dice è più che corretto. Ci deve essere una preoccupazione per l’impatto che l’AI può avere sull’uomo e sui diritti dell’uomo che devono essere rispettati. Ci deve essere rispetto per l’essere umano che viene coinvolto. Al momento, secondo me, questo non c’è. L’interesse delle aziende ora è solo arrivare sul mercato, arrivarci velocemente, sfondare tutto e poi, forse, chiedere scusa. Sempre se non sarà troppo tardi».